Contenido

- Definición - ¿Qué significa el Código Hamming?

- Una introducción a Microsoft Azure y la nube de Microsoft | A lo largo de esta guía, aprenderá de qué se trata la computación en la nube y cómo Microsoft Azure puede ayudarlo a migrar y administrar su negocio desde la nube.

- Techopedia explica el código de Hamming

Definición - ¿Qué significa el Código Hamming?

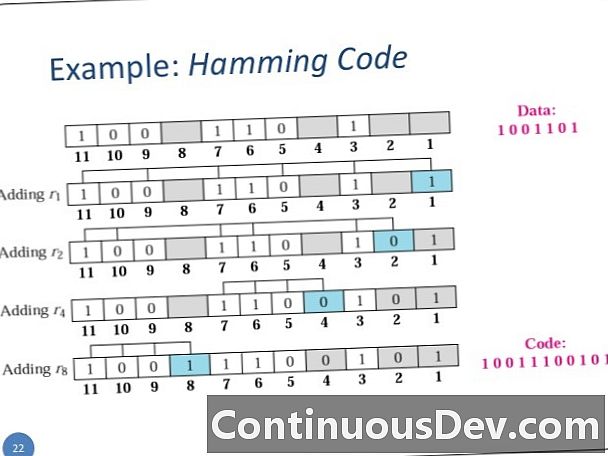

Un código de Hamming es un código lineal para la detección de errores que puede detectar hasta dos errores de bits simultáneos y es capaz de corregir errores de un solo bit. Se garantiza una comunicación confiable si la distancia entre el transmisor y el receptor es menor o igual a uno.

Una introducción a Microsoft Azure y la nube de Microsoft | A lo largo de esta guía, aprenderá de qué se trata la computación en la nube y cómo Microsoft Azure puede ayudarlo a migrar y administrar su negocio desde la nube.

Techopedia explica el código de Hamming

El código de Hamming fue inventado por Richard Hamming en 1950. El método es útil para un cambio de un solo bit, que es más probable que dos o más cambios de bit.

La simplicidad de los códigos hamming los hace adecuados para su uso en la memoria de la computadora y la corrección de un solo error. Usan una variante de detección de doble error llamada SECDED. Estos códigos tienen una distancia de hamming mínima de tres, donde el código detecta y corrige errores simples, mientras que los errores de doble bit solo se detectan si no se intenta una corrección. Agregar un bit de paridad adicional aumenta la distancia mínima del código de hamming a cuatro, lo que permite que el código detecte y corrija errores únicos mientras detecta errores dobles.

Hamming introdujo inicialmente un código que incluía cuatro bits de datos en siete bits al agregar tres bits de paridad. Se puede extender fácilmente a código de ocho y cuatro bits agregando un bit de paridad adicional en la parte superior de la palabra codificada.